|

|

La conscience des machines en débat Pour le neuroscientifique Stanislas Dehaene de futurs algorithmes permettront aux robots et aux logiciels d'accéder à un état de conscience proche de celui de l'humain. Des affirmations qui font réagir les spécialistes de l'intelligence artificielle Propos recueillis par Elena Sender Sciences et Avenir – janvier 2018 N°02667 |

|||

| INTELLIGENCE : Ensemble des processus mentaux d'une entité qui lui permet de se comporter de façon adaptée dans son environnement. CONSCIENCE : Phénomène mental qui permet à une entité de percevoir son existence et celle des autres, et de se les représenter dans son environnement. INTELLIGENCE ARTIFICIELLE : La science dont le but est de faire réaliser par une machine des tâches que l'homme accomplit en utilisant son intelligence (Marvin Minsky, 1956). |

|||

|

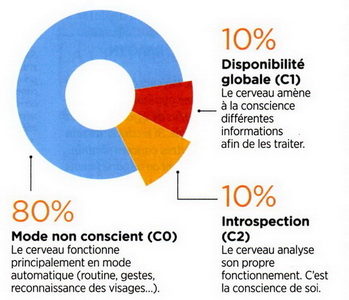

. | Selon le modèle proposé par Stanislas Dehaene, une petite partie seulement du cerveau humain permet l'accès à la conscience, son fonctionnement étant en majorité non conscient. voir : LE + NUMERIQUE Une interview de Yuval Noah Harari sur l'intelligence et la conscience : Way. fr/851harari et https://www.college-de-france.fr/site/stanislas-dehaene/p1319400748114720_content.htm |

|

Pour asséner cette affirmation, les trois spécialistes s'appuient sur plus d'une décennie d'expériences sur le cerveau humain qui, selon eux, a permis d'établir le schéma suivant : dans ses actions routinières (gestes, reconnaissance des visages et des sons, etc.), le cerveau fonctionnerait principalement en mode "non conscient" (ou inconscient), qu'ils appellent C0. Pour accéder à la conscience, il suffirait, selon Stanislas Dehaene, "d'une couche de calcul supplémentaire" qu'il nomme "disponibilité globale" (C1). Soit une phénoménale capacité de traitement de l'information. « C'est ce processus qui nous permet de faire remonter à notre conscience toutes les informations nécessaires à un instant donné, explique Sid Kouider. Ainsi, lorsque nous rencontrons quelqu'un, nous faisons appel à des informations situées dans différentes zones du cerveau comme la reconnaissance des visages, la mémoire ou la sémantique pour mettre aussitôt un nom sur cette personne. » Deux types de traitement de l'information En imagerie cérébrale, cette « prise de conscience » se traduit par un embrasement du cortex préfrontal, ces zones se mettant à dialoguer. « Grâce à Cl, l'information devient consciente, disponible, et peut donc être exprimée. » Toutefois, ce processus est insuffisant pour atteindre une conscience totale car, comme chacun a pu en faire l'expérience, nous pouvons fort bien reconnaitre quelqu'un... sans parvenir à se souvenir de son nom. « Néanmoins, dans ce cas précis, nous savons... que nous ne savons pas, poursuit Sid Kouider. Et cette étape fait appel à un deuxième type de traitement de l'information : l'introspection ou métacognition, c'est-à-dire la conscience de soi (C2). » Cl et C2 seraient ainsi pour ces chercheurs les deux piliers indispensables de notre système conscient. Les superordinateurs comme le britannique AlphaGo ou les américains Watson d'IBM ou Libratus — qui ont tous trois montré leurs capacités à surpasser les humains respectivement au jeu de go, au Jeopardy ou au poker — ont-ils accédé à ces niveaux de conscience ? « Non! », répondent fermement les trois spécialistes. Pour eux, « les calculs mis en oeuvre correspondent encore principalement aux opérations non conscientes du cerveau humain (C0). » Ce qui serait aussi le cas pour les agents conversationnels, ces logiciels qui simulent pourtant de mieux en mieux notre comportement (réf.). Mais Stanislas Dehaene et ses cosignataires en sont convaincus : Cl et C2 sont à portée des futurs algorithmes. Pour atteindre le premier, il suffirait d'« un super-système de partage et de coordination des informations», selon Sid Kouider, soit des architectures informatiques de partage massif et coordonné de l'information qui n'existent pas encore. Quant à la conscience de soi (C2), elle viendra un jour de programmes d'auto-apprentissage capables de s'évaluer et se corriger. L'épineux problème du rapport corps-esprit Une affirmation qui laisse David Sadek, vice-président recherche et innovation de Thales, sceptique : « Il existe déjà des programmes qui peuvent surveiller leur propre progression d'apprentissage ou avoir un raisonnement introspectif sur leurs propres connaissances, voire produire du code de façon automatique. Mais peut-on pour autant parler de conscience de soi ? Elle serait dans ce cas plutôt formelle et plus qu'embryonnaire. » Stanislas Dehaene l’assure pourtant : « Ces opérations sont des calculs et il n'y a pas de raison qu'on ne puisse pas les introduire dans les machines. » Même s'il admet que cette proposition est extrêmement computationnelle"* ». « Je doute vraiment qu'un coup de foudre amoureux ou une rage de dents puissent être considérés comme un état computationnel"* ! » réagit Christof Koch, directeur du Brain Allen Institute, à Seattle (Etats-Unis). Pour ce pionnier de la recherche des corrélats neuronaux de la conscience, celleci est « une expérience subjective phénoménale. Les ordinateurs pourront-ils jamais ressentir les couleurs, les sons, les odeurs, les émotions? » Le chercheur remarque d'ailleurs que ses confrères ont relégué cette question au dernier paragraphe de leur article, évitant ainsi l'épineux problème du rapport corps-esprit. « Même si les machines atteignent un jour C1 ou C2, rien ne prouve qu'elles auront des sentiments subjectifs. Elles seront peut-être capables de se comporter comme nous en apparence mais elles ne seront que des zombies. » Même scepticisme chez Jean-Claude Heudin, professeur et chercheur en intelligence artificielle : « Pour être "consciente", *** |

|||

L'intelligence artificielle doit encore faire des progrès |

||

|

Les IA actuelles sont-elles plus ou moins conscientes? Non. Pour s'assurer qu'un être vivant possède une conscience, on peut recourir au test du miroir. Celui-ci consiste à lui poser une étiquette sur la tête avant de le placer devant un miroir. Des espèces (singes, éléphants, dauphins, certains oiseaux) enlèvent aussitôt le papier, y compris les bébés humains dès 18 mois. Mais ce test est insuffisant car on peut programmer un robot pour qu'il 1e réussisse. Certes, on peut considérer que l'ordinateur et le cerveau humain sont des systèmes comparables, capables de manipuler des symboles. Mais nous sommes loin de la complexité du vivant. L'ordinateur n'a pas de viscères, ni de ressenti, ni d'appétit de vie à moins que l'humain n'en false une simulation. Ainsi, l'émergence d'une conscience artificielle dotée de sentiments, de pensées et de libre arbitre — sans programmation humaine ! — n'a aucune chance de se produire avec les architectures d'ordinateurs actuelles. Pour qu'elle emerge, il faudrait une hybridation entre le biologique et le silicium. Ce qui nécessitera d'en contrôler les comportements par des règles éthiques : c'est crucial. |

|

|

CHRISTOF KOCH DIRECTEUR DU BRAIN ALLEN INSTITUTE, A SEATTLE (ETATS-UNIS), AUTEUR DE CONSCIOUSNESS, MITPRESS, 2017). Aura-t-on un jour des machines conscientes? Oui et non... Notre société va créer des machines dotées d'une intelligence et de comportements humains capables de comprendre la parole, de se souvenir du passé et d'anticiper, d'écrire des livres, conduire, voter et, inevitablement, combattre. A partir de là, grâce au big data (données massives), à la puissance du deep learning (apprentissage profond) et à la rapidité de l'informatique, un pas sera franchi vers le dépassement de l'humain. Tant que ces machines seront construites sur les architectures informatiques actuelles, elles ne ressentiront rien. Pour être conscientes, elles devront être élaborées sur le modèle du cerveau humain comme l'a théorisé mon collègue Giulio Tononi, neuroscientifique l'université du Wisconsin (Etats-Unis) avec sa théorie de l'information intégrée : le degré global de conscience d'un système dépend de la façon dont il est construit et non sur ce qu'il fait. Ainsi, une machine avec une architecture "neuromorphique", semblable au système nerveux, c'est-à-dire capable de stocker un grand nombre d'informations et de développer une interconnexion entre ses parties, pourrait, en principe, être dotée de conscience. |

|